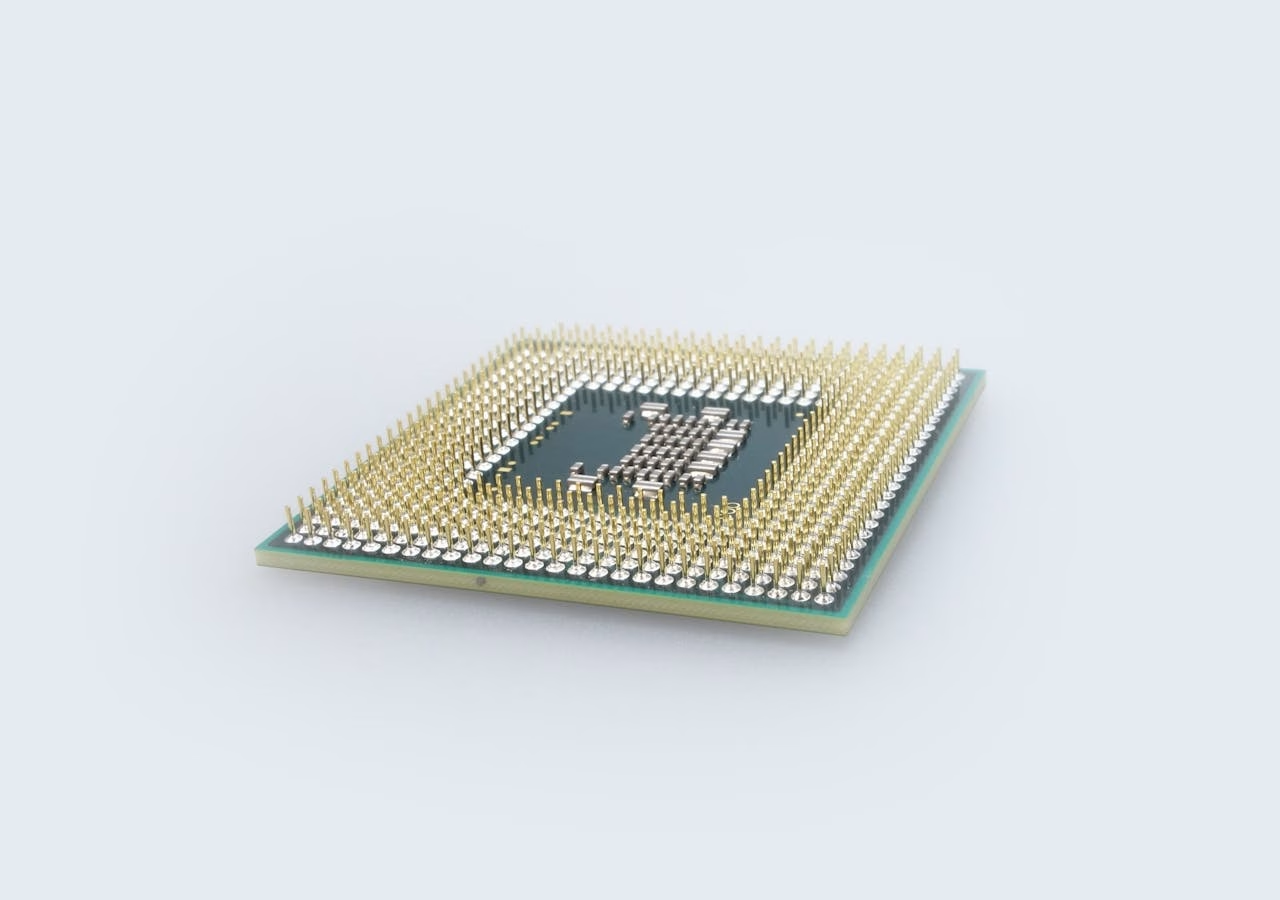

Los chips de Amazon para inteligencia artificial están bajo la lupa. Según documentos internos citados por el medio Business Insider, varias startups habrían detectado problemas de rendimiento y disponibilidad en los procesadores Trainium 1 y 2, que no alcanzarían el nivel de las GPU H100 de Nvidia. Algunos informes mencionan accesos “extremadamente limitados” e interrupciones recurrentes en el servicio.

Entre los casos mencionados figura Cohere, que habría registrado resultados “por debajo” de las H100 y fallos aún “en investigación” por parte de Annapurna Labs, la división de chips de Amazon. Stability AI también habría concluido que Trainium 2 no iguala la latencia ni la eficiencia de las GPU de Nvidia, lo que las haría menos competitivas tanto en velocidad como en coste.

Amazon, sin embargo, rechaza esa lectura. En respuesta al medio, un portavoz de la compañía señaló que agradecen el feedback de los clientes y que el caso de Cohere “no es actual”. La compañía defiende que Trainium e Inferentia han conseguido buenos resultados con empresas como Ricoh, Datadog o Metagenomi, y subraya que el uso de Trainium 2 “crece de forma sostenida”, sobre todo entre grandes clientes como Anthropic.

AWS sostiene que sus chips ofrecen entre un 30 % y un 40 % mejor relación precio-rendimiento que las GPU actuales y asegura que Trainium 3, previsto para este año, ampliará el acceso a más compañías. “Seguiremos innovando para ofrecer la mejor relación entre coste y rendimiento”, afirmó la empresa. En palabras del CEO Andy Jassy, Trainium 2 ya es un producto “totalmente suscrito” y representa un negocio de “varios miles de millones”.

No obstante, otros clientes relatan una experiencia distinta. La startup Typhoon habría constatado que las A100 de Nvidia son hasta tres veces más eficientes en coste que Inferentia 2, mientras que AI Singapore habría logrado mejores resultados con los servidores G6 de AWS, también impulsados por Nvidia. Según datos de Omdia, Nvidia domina el 78 % del mercado de chips de IA, muy por delante de Google, AMD y AWS, que apenas alcanza el 2 %.

A largo plazo, Amazon busca reducir su dependencia de Nvidia, siguiendo la estrategia que ya aplicó en sus centros de datos con chips propios. Pero la preferencia de muchos clientes por el hardware de Nvidia podría presionar sus márgenes si AWS se ve obligada a contratar GPU externas. En el corto plazo, la compañía confía en que la llegada de Trainium 3 y el aprendizaje obtenido de los despliegues actuales marquen un punto de inflexión en su apuesta por la computación de IA.